Heute kam ein neues Smart TV, das alte hat nach ca. 13 Jahren den Geist aufgegeben (genauer: verständlichen Ton aufgegeben) Dyon heißt die Marke, hatte ich noch nie gehört, angeblich sogar ein deutscher Hersteller (https://www.dyon.eu/) — ich glaube das nicht, vermutlich kommen die Geräte doch direkt aus China.

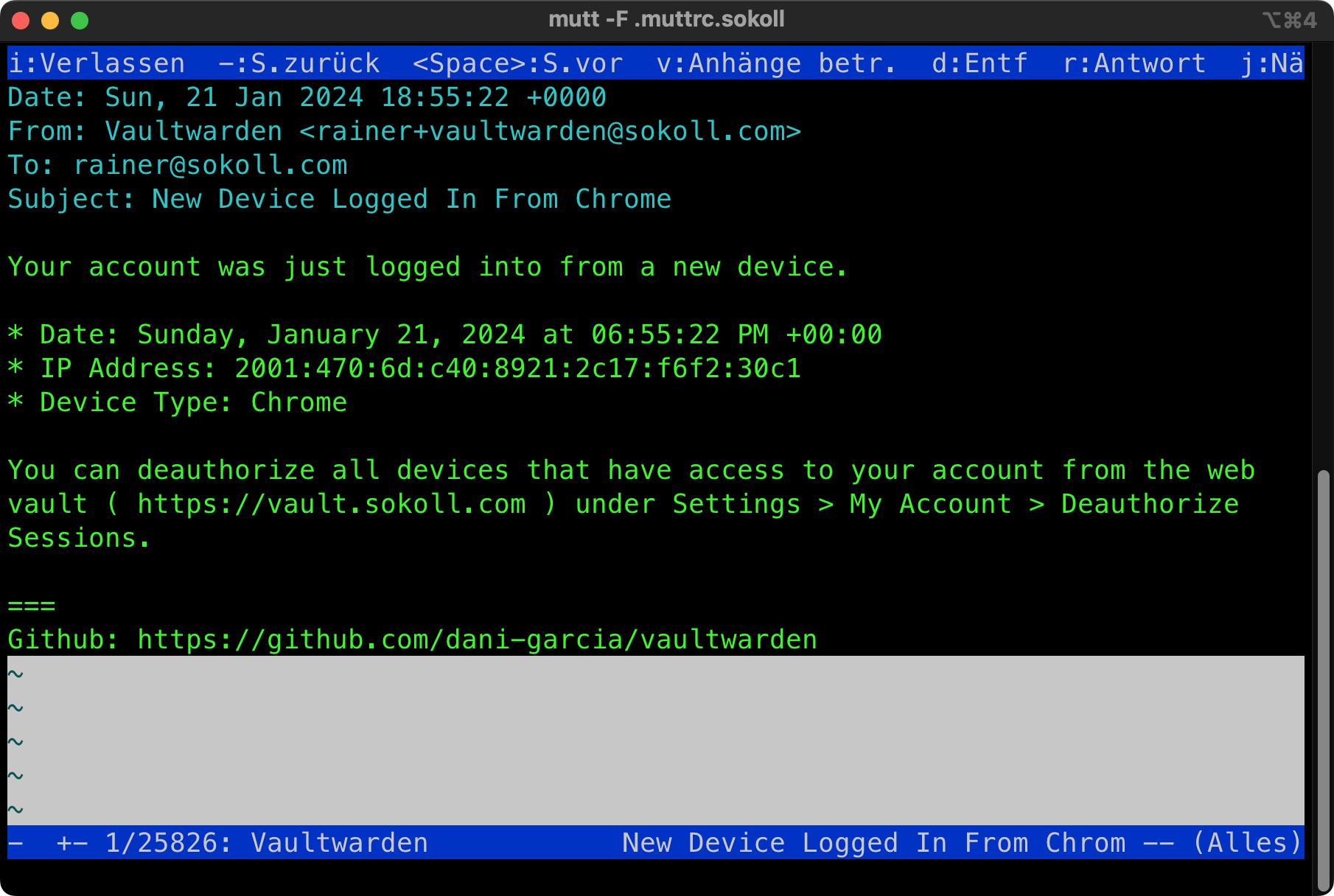

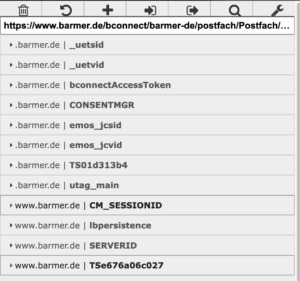

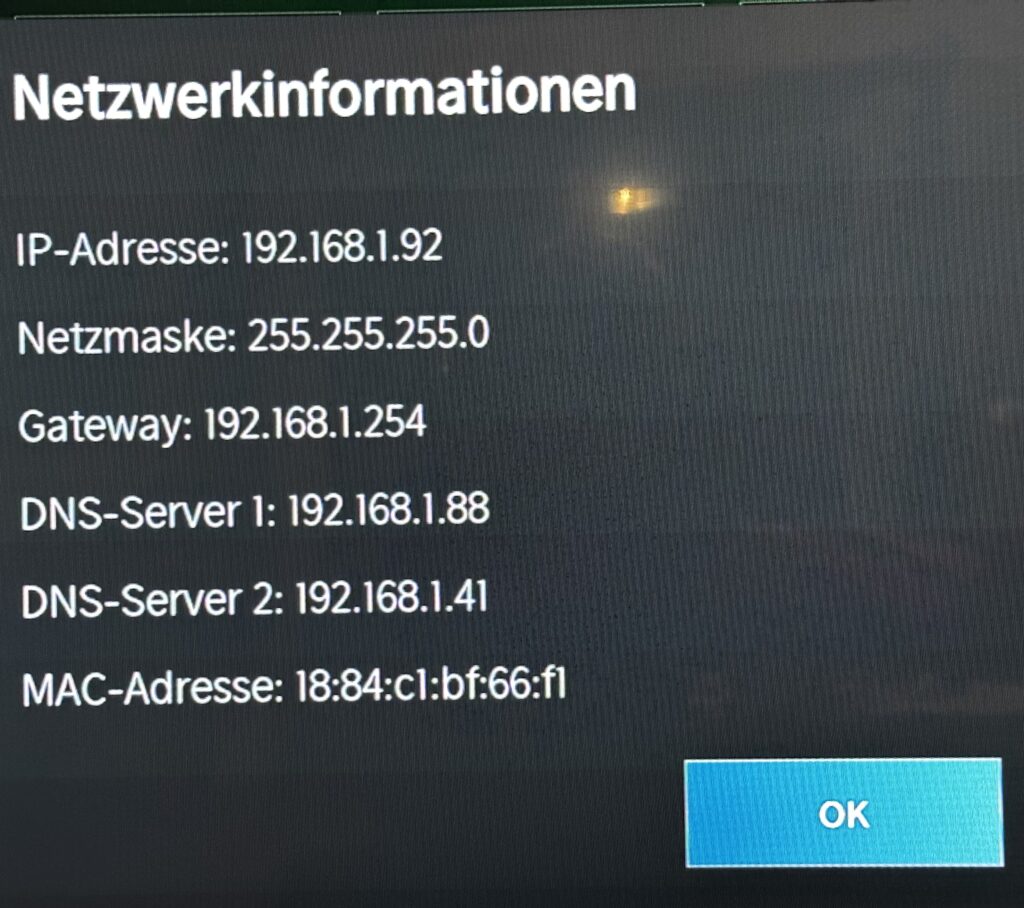

Da wir kein Antennen- oder Sat-TV haben, ging die Inbetriebnahme schnell vonstatten, auch Netz war sofort da:

Die 192.168.1.88 ist ein pihole, der Fernseher soll ja auch was gutes bekommen.

Alles funktioniert also, die diversen Streaming-Dienste sind eingerichtet und funktionieren.

Abschließend werfe ich noch einen Blick in die Logs des pihole um zu sehen, zu welchen Heimtelefonier-Seiten der Fernseher petzen möchte. Stellt sich raus: Der Fernseher benutzt den pihole gar nicht! (und auch nicht die 192.168.1.41)

Ein Verdacht kommt auf. Ich logge mich also auf dem Router ein und mache:

root@sokoll-router:/config# tcpdump -i switch0 -n host 192.168.1.92 and port 53

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on switch0, link-type EN10MB (Ethernet), capture size 262144 bytes

21:17:09.293692 IP 192.168.1.92.49962 > 8.8.8.8.53: 45092+ AAAA? logs.netflix.com. (34)

21:17:09.293699 IP 192.168.1.92.49962 > 8.8.8.8.53: 17557+ AAAA? nrdp.prod.cloud.netflix.com. (45)

21:17:09.293704 IP 192.168.1.92.49962 > 8.8.8.8.53: 15435+ A? nrdp51-appboot.netflix.com. (44)

21:17:09.293708 IP 192.168.1.92.49962 > 8.8.8.8.53: 49981+ AAAA? nrdp51-appboot.netflix.com. (44)

21:17:09.293715 IP 192.168.1.92.49962 > 8.8.8.8.53: 52581+ A? nrdp.nccp.netflix.com. (39)

21:17:09.293719 IP 192.168.1.92.49962 > 8.8.8.8.53: 42306+ AAAA? nrdp.nccp.netflix.com. (39)

21:17:09.293724 IP 192.168.1.92.49962 > 8.8.8.8.53: 27213+ A? api-global.netflix.com. (40)

21:17:09.321424 IP 192.168.1.92.49962 > 8.8.8.8.53: 60092+ A? logs.netflix.com. (34)

21:17:09.344818 IP 8.8.8.8.53 > 192.168.1.92.49962: 45092 6/0/0 CNAME logs.dradis.netflix.com., CNAME logs.eu-west-1.internal.dradis.netflix.com., CNAME apiproxy-logging-7d0bf81651765786.elb.eu-west-1.amazonaws.com., AAAA 2a05:d018:76c:b684::5a89:1099, AAAA 2a05:d018:76c:b680::5a89:1099, AAAA 2a05:d018:76c:b682::5a89:1099 (254)

21:17:09.346588 IP 8.8.8.8.53 > 192.168.1.92.49962: 17557 6/0/0 CNAME nrdp.prod.dradis.netflix.com., CNAME nrdp.prod.eu-west-1.internal.dradis.netflix.com., CNAME apiproxy-nrdp-prod-nlb-1-bc4243efc68f31ae.elb.eu-west-1.amazonaws.com., AAAA 2a05:d018:76c:b685:9ae6:e07a:670d:52e4, AAAA 2a05:d018:76c:b683:194f:a5df:2ad1:ab02, AAAA 2a05:d018:76c:b684:b7f5:7e97:3e99:751e (283)

21:17:09.346728 IP 8.8.8.8.53 > 192.168.1.92.49962: 52581 8/0/0 CNAME nrdp.nccp.dradis.netflix.com., CNAME nrdp.nccp.eu-west-1.origin.prodaa.netflix.com., A 52.19.104.71, A 52.49.155.216, A 54.76.160.164, A 52.210.130.122, A 52.210.124.147, A 52.18.41.61 (214)

21:17:09.346868 IP 8.8.8.8.53 > 192.168.1.92.49962: 49981 10/0/0 CNAME appboot.dradis.netflix.com., CNAME appboot.eu-west-1.origin.prodaa.netflix.com., AAAA 2a01:578:3::3410:ea4e, AAAA 2a01:578:3::34d3:322, AAAA 2a01:578:3::34d4:c576, AAAA 2a01:578:3::34d3:3154, AAAA 2a01:578:3::3430:8bf6, AAAA 2a01:578:3::369a:f1ed, AAAA 2a01:578:3::22f0:a04c, AAAA 2a01:578:3::36f6:b554 (343)

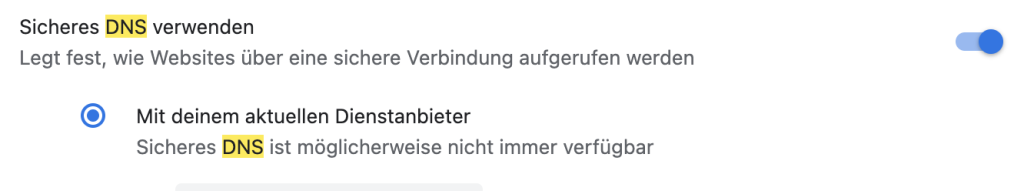

Au weia! Es wird ungebeten Googles DNS verwendet!

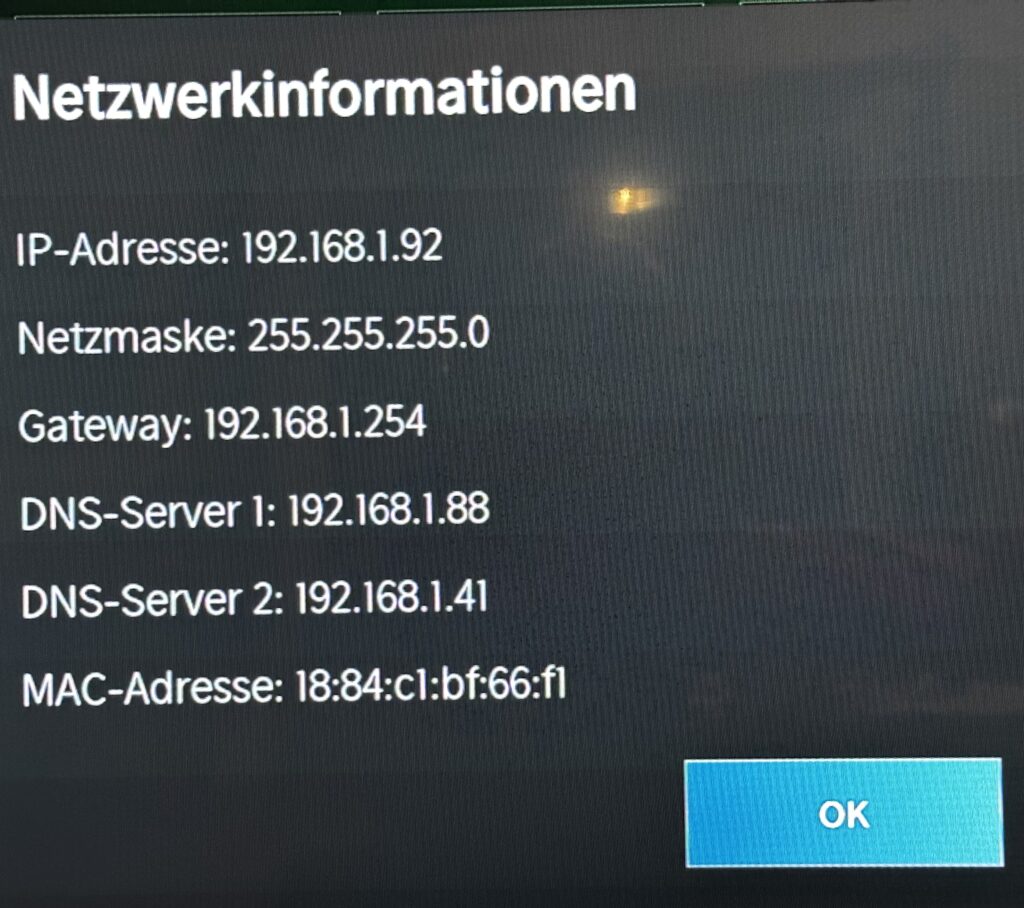

Fragen kommen auf: Das Teil erkennt die per DHCP zugewiesenen Nameserver — und verwendet sie nicht. Warum? DasTeil hat kein v6 und fragt doch nach AAAA. Warum?

Nun, ich ziseliere mir eine Firewall-Regel:

ubnt@sokoll-router:~$ show configuration commands

[…]

set firewall group address-group google-dns address 8.8.4.4

set firewall group address-group google-dns address 8.8.8.8

[…]

set firewall name LAN_OUT rule 20 action reject

set firewall name LAN_OUT rule 20 description 'Dem Fernseher Google DNS verbieten'

set firewall name LAN_OUT rule 20 destination group address-group google-dns

set firewall name LAN_OUT rule 20 destination port 53

set firewall name LAN_OUT rule 20 log disable

set firewall name LAN_OUT rule 20 protocol udp

set firewall name LAN_OUT rule 20 source address 192.168.1.92

set firewall name LAN_OUT rule 20 source mac-address '18:84:c1:bf:66:f1'

[…]

Und das wirkt, tataa!

root@sokoll-router:/config# tcpdump -i switch0 -n host 192.168.1.92 and port 53

tcpdump: verbose output suppressed, use -v or -vv for full protocol decode

listening on switch0, link-type EN10MB (Ethernet), capture size 262144 bytes

21:32:35.659906 IP 192.168.1.92.34723 > 8.8.8.8.53: 23537+ A? logs.netflix.com. (34)

21:32:35.659911 IP 192.168.1.92.34723 > 8.8.8.8.53: 44326+ AAAA? nrdp.prod.cloud.netflix.com. (45)

21:32:35.659916 IP 192.168.1.92.34723 > 8.8.8.8.53: 22112+ A? nrdp51-appboot.netflix.com. (44)

21:32:35.659920 IP 192.168.1.92.34723 > 8.8.8.8.53: 57120+ AAAA? nrdp51-appboot.netflix.com. (44)

21:32:35.659924 IP 192.168.1.92.34723 > 8.8.8.8.53: 44242+ A? nrdp.nccp.netflix.com. (39)

21:32:35.659928 IP 192.168.1.92.34723 > 8.8.8.8.53: 19783+ AAAA? nrdp.nccp.netflix.com. (39)

21:32:35.659932 IP 192.168.1.92.34723 > 8.8.8.8.53: 25321+ A? api-global.netflix.com. (40)

21:32:35.662950 IP 192.168.1.92.43839 > 8.8.8.8.53: 22191+ AAAA? api-global.netflix.com. (40)

21:32:35.662958 IP 192.168.1.92.43839 > 8.8.8.8.53: 64306+ A? secure.netflix.com. (36)

21:32:35.663031 IP 192.168.1.92.43839 > 8.8.8.8.53: 32983+ AAAA? secure.netflix.com. (36)

21:32:35.663041 IP 192.168.1.92.43839 > 8.8.8.8.53: 58766+ A? uiboot.netflix.com. (36)

21:32:35.663049 IP 192.168.1.92.43839 > 8.8.8.8.53: 59032+ AAAA? uiboot.netflix.com. (36)

21:32:35.663094 IP 192.168.1.92.43839 > 8.8.8.8.53: 47968+ A? customerevents.netflix.com. (44)

21:32:35.663132 IP 192.168.1.92.43839 > 8.8.8.8.53: 27882+ A? ichnaea.netflix.com. (37)

21:32:35.663181 IP 192.168.1.92.43839 > 8.8.8.8.53: 18226+ A? cdn-0.nflximg.com. (35)

21:32:35.663231 IP 192.168.1.92.43839 > 8.8.8.8.53: 20002+ A? nrdp.prod.ftl.netflix.com. (43)

21:32:35.663263 IP 192.168.1.92.43839 > 8.8.8.8.53: 42457+ AAAA? nrdp.prod.ftl.netflix.com. (43)

21:32:35.883642 IP 192.168.1.92.43839 > 8.8.8.8.53: 13421+ A? nrdp.prod.cloud.netflix.com. (45)

21:32:36.634192 IP 192.168.1.92.43839 > 8.8.8.8.53: 13421+ A? nrdp.prod.cloud.netflix.com. (45)

21:32:36.787647 IP 192.168.1.92.43839 > 8.8.8.8.53: 44242+ A? nrdp.nccp.netflix.com. (39)

Er befragt weiterhin Google, bekommt aber keine Antworten mehr 🤓

Und gleichzeitig füllt sich das Log vom pihole. Und natürlich funktioniert das Smart am TV immer noch.

Hm, mir fällt gerade auf, daß ich

set firewall name LAN_OUT rule 20 protocol udp

auf

set firewall name LAN_OUT rule 20 protocol all

ändern sollte, nicht daß das Teil auf TCP umschwenkt irgendwann.

Was machen 99% der SmartTV-Nutzer? Die haben weder das Wissen noch die Technik, dem Spionieren wenigstens ein wenig entgegenzutreten. Klar könnte man das Ethernet ziehen und einen Firestick oder so direkt an HDMI anflanschen. Aber ob der weniger spionieren würde?

Wobei ich sagen möchte: Dem TV-Hersteller werfe ich keine Bösartigkeit vor, er liefert seine Kunden mangels Sorgfalt einfach den Datenkraken aus, was im Endeffekt aber egal ist. Das TV soll einfach das annehmen, was man ihm sagt, und gut wäre es.